Z-Image

轻量级图片生成引擎

Z-Image 是一款轻量级图片生成工具,采用高效 8-Step 推理架构,在消费级 GPU 上实现快速、高质量的 AI 图像生成,显著降低算力成本。

Dimensions

示例展示

电影感暗调爵士萨克斯

东京雨夜街头纪实

手工制表匠人

唐朝汉服仕女特写

高级时装质感

吉卜力工作室插画

复古电影海报《回忆之味》

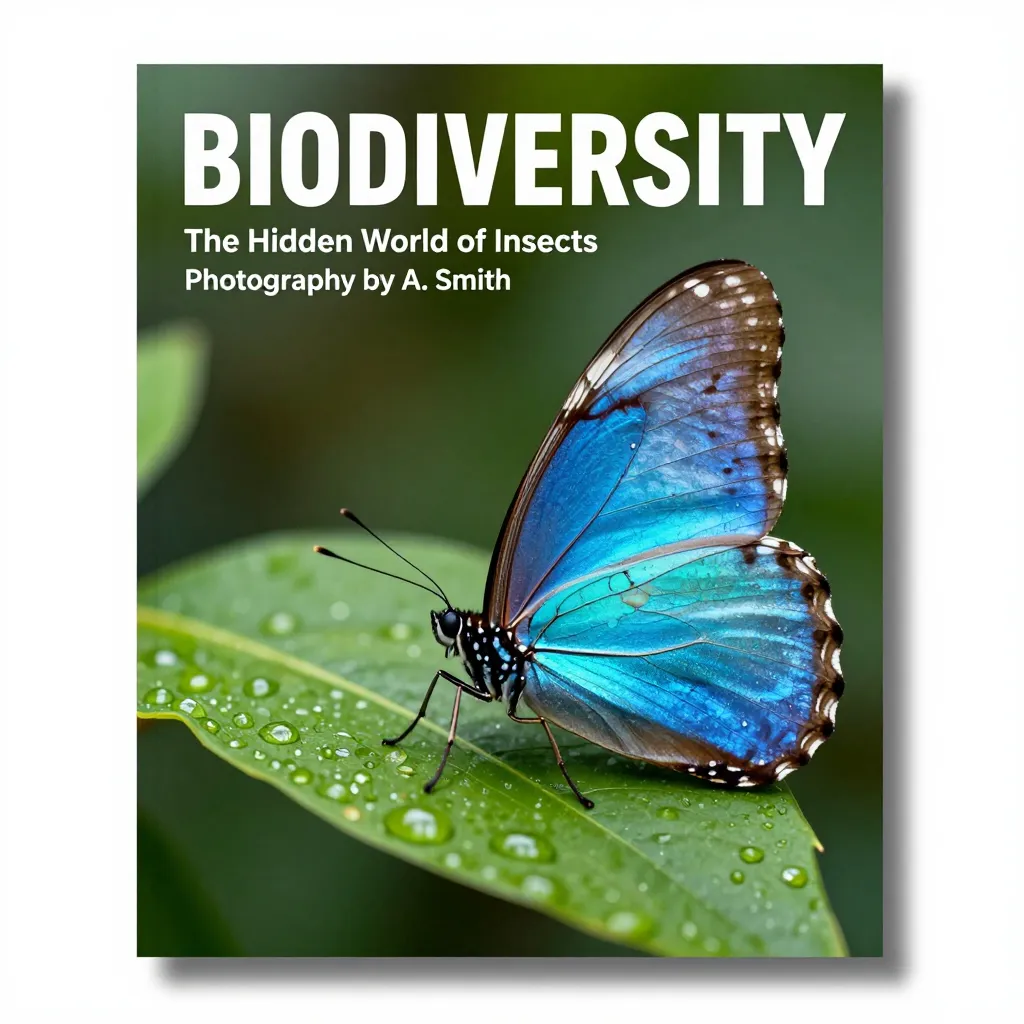

自然杂志封面

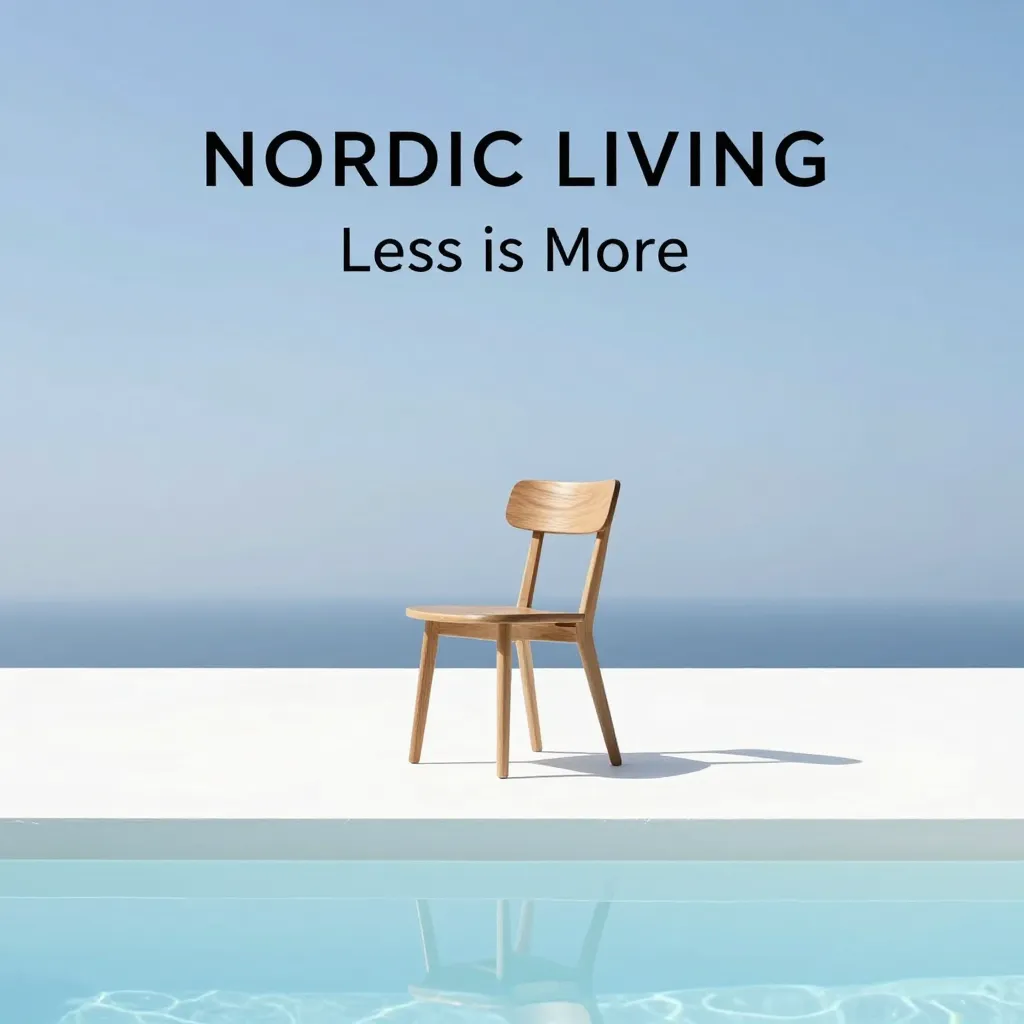

极简木椅海报设计

不仅仅是快,是全面进化

填补了轻量级模型与巨型模型之间的空白,Z-Image-Turbo 在速度、质量和易用性之间找到了完美的平衡点。

原生双语支持

内置 Qwen 3.4B 大语言模型作为大脑。不再有乱码的汉字,无论是书法、招牌还是复杂的中文排版,都能精准渲染。

S3-DiT 单流架构

激进的架构创新。将文本与图像 Token 统一处理,类似 GPT-4 的处理方式,每一分参数都在同时服务于图像生成和语义理解。

Apache 2.0 协议

真正的开源自由。不同于 Flux.1 的商业限制,您可以自由商用、修改、集成,是初创企业和游戏工作室的理想基座。

S3-DiT:打破模态壁垒

传统模型采用“双流”架构,图像和文本各跑各的。Z-Image-Turbo 采用 可扩展单流扩散 Transformer (S3-DiT)。

- 统一输入流:文本 Token 与图像 Latent 直接拼接。

- 全参数交互:每一层 Transformer 都在进行深度的图文注意力计算。

- 解耦分布匹配蒸馏 (Decoupled-DMD):将推理压缩至 8 步的核心算法。

- CFG 增强:独立优化引导信号,无需高 CFG 值即可获得清晰图像。

为什么选择 Z-Image-Turbo?

在性能、成本与生态之间,我们提供了最优解。

| 指标 | Z-Image-Turbo | Flux.1 (Dev) | SDXL Base |

|---|---|---|---|

| 参数量 | 6B (黄金平衡) | 12B (庞大) | 2.6B |

| 显存需求 | 12GB (原生 BF16) | 24GB+ (或量化) | 8GB |

| 推理步数 | 8 步 (Distilled) | 20-50 步 | 20-50 步 |

| 文本编码器 | Qwen 3.4B (中英双语) | T5 + CLIP | OpenCLIP |

| 中文排版 | ⭐️⭐️⭐️⭐️⭐️ 完美 | ⭐️⭐️ 较差 | ⭐️ 乱码 |

| 开源协议 | Apache 2.0 (可商用) | Non-Commercial | OpenRAIL++ |

| 单图成本 | ~$0.0029 | 高昂 | 低 |

消费级硬件的福音

得益于 6B 参数规模和 8 步蒸馏技术,Z-Image-Turbo 可以在 RTX 3090/4090 等显卡上实现 2-3 秒的高清出图。对于企业用户,H800 更是能实现亚秒级响应。

快速上手

# 使用 Diffusers 快速加载

from diffusers import DiffusionPipeline

import torch

# 加载 8-Step Turbo 模型

pipe = DiffusionPipeline.from_pretrained(

"Tongyi-MAI/Z-Image-Turbo",

torch_dtype=torch.bfloat16

).to("cuda")

# 生成图像

image = pipe(

prompt="赛博朋克侦探,雨夜,霓虹灯,中文招牌写着"通义实验室"",

num_inference_steps=8,

guidance_scale=1.0 # 蒸馏模型无需高 CFG

).images[0]

常见问题解答

关于模型部署、使用与授权的疑问。

Z-Image-Turbo 对显卡有什么要求?

对于原生精度(BF16)运行,推荐使用 16GB VRAM 或更高的显卡。如果使用 GGUF/NF4 量化版本,8GB VRAM 的显卡也可以流畅运行,且画质损失极小。

它可以用于商业项目吗?

完全可以。 Z-Image-Turbo 采用宽松的 Apache 2.0 许可证。这意味着您可以免费将其用于商业用途,无需支付授权费。

如何书写中文 Prompt?

像与人聊天一样自然即可。得益于 Qwen 3.4B 强大的语言理解能力,您可以使用复杂的中文长句。如果需要生成特定文字,请使用引号包裹。

是否支持 ComfyUI 和 WebUI?

是的。ComfyUI 已实现零日支持(Day-0 Support)。Automatic1111 WebUI 的支持也在开发分支中,预计近期合并。

相比 Flux.1,它的优势在哪里?

Z-Image-Turbo 主要是为了解决 效率 和 易用性 问题。推理速度快了 3 倍,显存占用少了一半,并且对中文的支持远超 Flux。