Z-Image

輕量級圖片生成引擎

Z-Image 是一款輕量級圖片生成工具,採用高效 8-Step 推論架構,在消費級 GPU 上實現快速、高質量的 AI 圖像生成,顯著降低算力成本。

Dimensions

示例展示

電影感暗調爵士薩克斯

東京雨夜街頭紀實

手工製表匠人

唐朝漢服仕女特寫

高級時裝質感

吉卜力工作室插畫

復古電影海報《回憶之味》

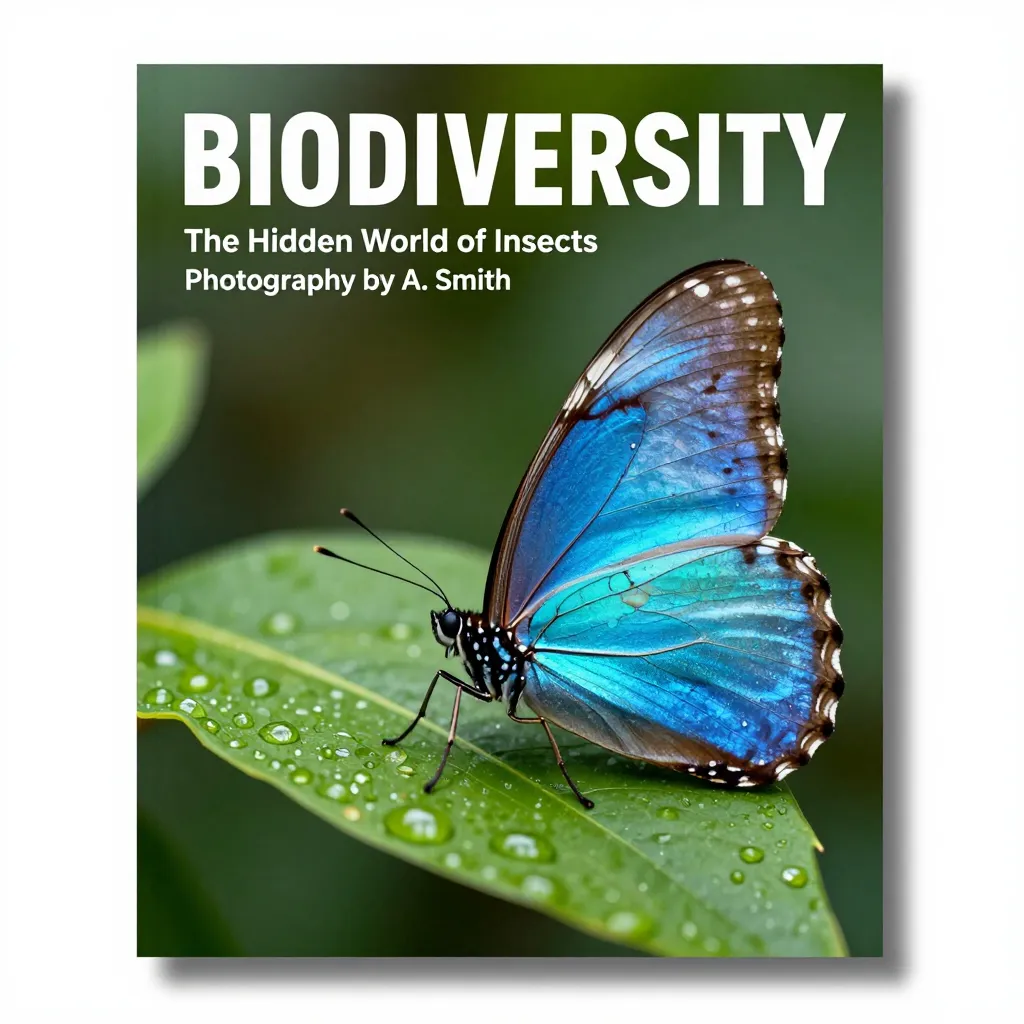

自然雜誌封面

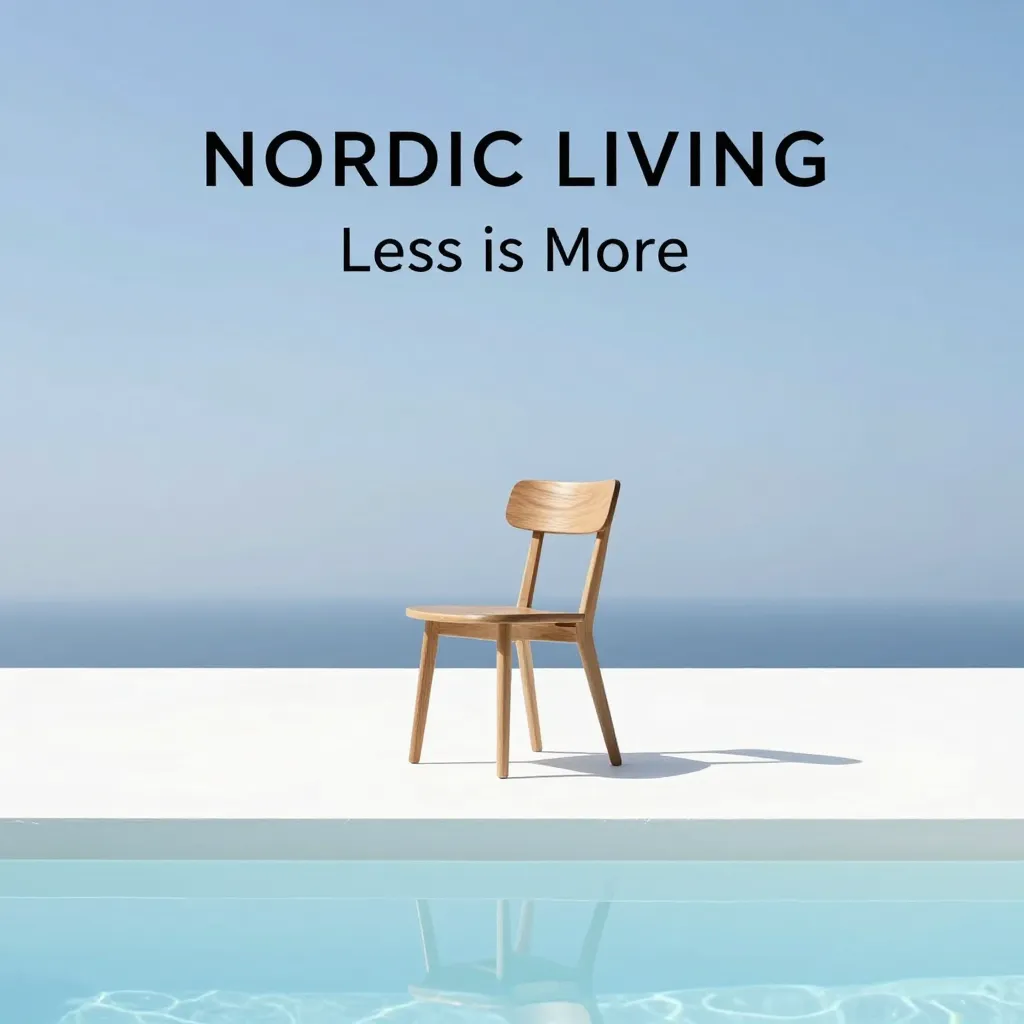

極簡木椅海報設計

不僅僅是快,是全面進化

填補了輕量級模型與巨型模型之間的空白,Z-Image-Turbo 在速度、質量和易用性之間找到了完美的平衡點。

原生雙語支援

內建 Qwen 3.4B 大語言模型作為大腦。不再有亂碼的漢字,無論是書法、招牌還是複雜的中文排版,都能精準渲染。

S3-DiT 單流架構

激進的架構創新。將文本與圖像 Token 統一處理,類似 GPT-4 的處理方式,每一分參數都在同時服務於圖像生成和語義理解。

Apache 2.0 協議

真正的開源自由。不同於 Flux.1 的商業限制,您可以自由商用、修改、集成,是初創企業和遊戲工作室的理想基座。

S3-DiT:打破模態壁壘

傳統模型採用「雙流」架構,圖像和文本各跑各的。Z-Image-Turbo 採用 可擴展單流擴散 Transformer (S3-DiT)。

- 統一輸入流:文本 Token 與圖像 Latent 直接拼接。

- 全參數交互:每一層 Transformer 都在進行深度的圖文注意力計算。

- 解耦分佈匹配蒸餾 (Decoupled-DMD):將推論壓縮至 8 步的核心演算法。

- CFG 增強:獨立優化引導信號,無需高 CFG 值即可獲得清晰圖像。

為什麼選擇 Z-Image-Turbo?

在性能、成本與生態之間,我們提供了最優解。

| 指標 | Z-Image-Turbo | Flux.1 (Dev) | SDXL Base |

|---|---|---|---|

| 參數量 | 6B (黃金平衡) | 12B (龐大) | 2.6B |

| 顯存需求 | 12GB (原生 BF16) | 24GB+ (或量化) | 8GB |

| 推論步數 | 8 步 (Distilled) | 20-50 步 | 20-50 步 |

| 文本編碼器 | Qwen 3.4B (中英雙語) | T5 + CLIP | OpenCLIP |

| 中文排版 | ⭐️⭐️⭐️⭐️⭐️ 完美 | ⭐️⭐️ 較差 | ⭐️ 亂碼 |

| 開源協議 | Apache 2.0 (可商用) | Non-Commercial | OpenRAIL++ |

| 單圖成本 | ~$0.0029 | 高昂 | 低 |

消費級硬體的福音

得益於 6B 參數規模和 8 步蒸餾技術,Z-Image-Turbo 可以在 RTX 3090/4090 等顯示卡上實現 2-3 秒的高清出圖。對於企業用戶,H800 更是能實現亞秒級響應。

快速上手

# 使用 Diffusers 快速載入

from diffusers import DiffusionPipeline

import torch

# 載入 8-Step Turbo 模型

pipe = DiffusionPipeline.from_pretrained(

"Tongyi-MAI/Z-Image-Turbo",

torch_dtype=torch.bfloat16

).to("cuda")

# 生成圖像

image = pipe(

prompt="賽博龐克偵探,雨夜,霓虹燈,中文招牌寫著"通義實驗室"",

num_inference_steps=8,

guidance_scale=1.0 # 蒸餾模型無需高 CFG

).images[0]

常見問題解答

關於模型部署、使用與授權的疑問。

Z-Image-Turbo 對顯示卡有什麼要求?

對於原生精度(BF16)運行,推薦使用 16GB VRAM 或更高的顯示卡。如果使用 GGUF/NF4 量化版本,8GB VRAM 的顯示卡也可以流暢運行,且畫質損失極小。

它可以用於商業專案嗎?

完全可以。 Z-Image-Turbo 採用寬鬆的 Apache 2.0 許可證。這意味著您可以免費將其用於商業用途,無需支付授權費。

如何書寫中文 Prompt?

像與人聊天一樣自然即可。得益於 Qwen 3.4B 強大的語言理解能力,您可以使用複雜的中文長句。如果需要生成特定文字,請使用引號包裹。

是否支援 ComfyUI 和 WebUI?

是的。ComfyUI 已實現零日支援(Day-0 Support)。Automatic1111 WebUI 的支援也在開發分支中,預計近期合併。

相比 Flux.1,它的優勢在哪裡?

Z-Image-Turbo 主要是為了解決 效率 和 易用性 問題。推論速度快了 3 倍,顯存佔用少了一半,並且對中文的支援遠超 Flux。